Contexte général et enjeux

L’essor de l’open data, le développement de nouveaux capteurs (satellites, aériens ou drones), la multiplication des plates-formes de diffusion offrent une facilité grandissante d’accès à la donnée d’imagerie. D’autre part, le développement des capacités de stockages de données et l’augmentation des puissances de calcul permettent de développer plus facilement les méthodes dites d’intelligence artificielle. Ces deux effets combinés participent à la démultiplication de l’information.

Le Pôle observation des territoires et applications satellitaires du Cerema est impliqué dans l’exploitation d’imagerie spatiale optique ou radar pour produire des données utiles à la connaissance des territoires. Les méthodes et outils développées se basent sur l’état de l’art de la recherche, tout en se plaçant dans des conditions d’usages opérationnels pour les services en charge de l’aménagement du territoire.

Penser des solutions opérationnelles doit s’inscrire dans une logique de reproductibilité et d’accompagnement des produits pour leur usage. Dans cette optique, la qualification des données est essentielle. Une série d’études spécifiques sur l’évaluation de la qualité des résultats obtenus sur divers travaux de télédétection du Pôle a été menée.

Description des données évaluées

Les données analysées sont des couches d’occupation du sol et des indicateurs qui en sont dérivés. Ils sont basés sur :

-

les images satellitaires Rapideye, Spot 6/7 ou Pleiades avec un modèle 3D associé,

-

une méthode de production d’échantillonnage des données d’apprentissage semi-automatique,

-

des algorithmes de classification basés sur du machine learning,

-

éventuellement des post-traitements supervisés voire des post-traitements manuels plus poussés.

Cadrage des travaux

Plusieurs approches peuvent être mobilisées pour qualifier les données géospatiales. Dans le champ de la télédétection, notamment en recherche, on observe principalement l’usage de matrices de confusion et d’indicateurs statistiques souvent déconnectés de l’usage de la donnée. De plus, les protocoles de production des données de référence sont rarement décrits.

La norme ISO 19157 offre un cadre normatif à la description de la qualité des données géographiques. Elle a fait l’objet d’une publication par le Cerema d’une série de fiches méthodologiques : « Qualifier les données géographiques - Un décryptage de la norme ISO 19157 » 1

Cette norme est une avancée majeure sur la question de la qualification des données :

-

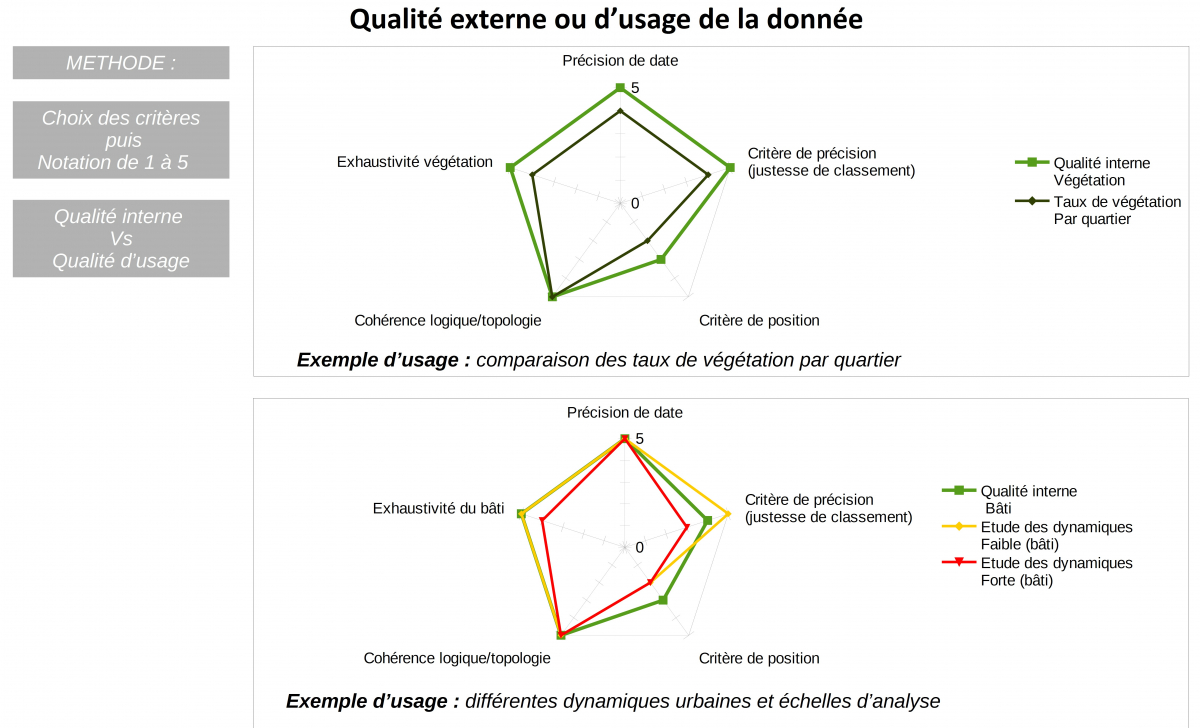

En particulier, la norme établit la distinction entre les notions fondamentales de qualité interne (dite intrinsèque) et de qualité externe (dite d’usage), à savoir : d’une part, le produit répond-il aux spécifications qui ont précédées la mise en production ? d’autre part, le produit correspond-il bien à l’usage que je veux en faire ?

-

Elle dote les producteurs de données d’outils et de méthodes pour fiabiliser l’exploitation de la donnée par les utilisateurs finaux.

Méthode mise en œuvre par le Cerema :

La directive Inspire précise les métadonnées relatives à la qualité. La norme ISO 19157 fournit des éléments sur la manière de les renseigner. Une étude a été menée pour appliquer cette méthodologie aux produits d’occupation du sol au format raster.

Ce travail a permis de mettre en évidence certains points de la norme :

-

elle a été essentiellement définie pour l’évaluation des produits au format vectoriel,

-

elle apporte des éléments sur la définition de données de référence mais demeure très permissive sur les processus de production de ces échantillons,

-

elle apporte une plus-value sur les méthodes pour évaluer l’adéquation d’une qualité interne au regard d’un usage. Cependant, elle laisse une grande autonomie pour mettre en œuvre cette évaluation.

Adaptation au format raster

-

La question de la donnée raster a été traitée en préférant une qualification par pixel.

-

Le choix des points se fait par un tirage aléatoire ; le nombre de point est déterminé par une formule statistique, prenant en compte le nombre de labels et leur répartition. Cette méthode permet d’objectiver le choix des échantillons de référence et d’assurer leur représentativité.

Définition de la référence

-

Une incertitude porte sur la subjectivité des opérateurs qui produisent la donnée de référence. Un guide d’interprétation adapté au produit a été rédigé. Les différences d’interprétation ont fait l’objet d’une réconciliation collégiale entre les opérateurs.

-

Le choix a été fait d’utiliser l’image satellite source pour produire la référence par photo-interprétation. Cela permet de s’affranchir des problématiques de décalages temporels et spatiaux, voire de différences de spécification dans le cas d’usage de bases de données externes.

Réflexions sur la qualité d’usage

-

la qualification des données est réalisée à une échelle particulière, inhérente au projet (département, métropole, quartier,...). La spatialisation des erreurs peut varier en fonction des paysages, donc des échelles d’utilisation de la donnée.

-

la qualité d’usage peut se voir entachée de nouvelles erreurs en particulier lorsqu’on travaille sur des indicateurs croisant plusieurs bases de données. On peut également observer des effets d’atténuation ou de démultiplication des erreurs.

Doctrine pour une production générique

-

la qualification des données est réalisée pour une date définie, ici la date d’acquisition de l’image satellite. Or la qualité de l’image, composition de l’atmosphère, ombres portées ou angles d’acquisition, dynamique de végétation, par exemple ont un impact direct sur la qualité des résultats produits par les algorithmes et la production des données de références. Une donnée et sa méthode de production associée sont qualifiées pour une date donnée et non de manière générique.

-

La promesse de l’imagerie spatiale est de pouvoir revisiter régulièrement les territoires à faible coût pour suivre des dynamiques, mais cela soulève une difficulté sur la mesure des erreurs qu’il conviendrait de répéter. Il serait souhaitable de pouvoir accompagner un produit générique par une incertitude qui l’encadrerait quelles que soient les conditions.

Mise en perspective et comparaison avec d’autres bases de données

A ce stade, les résultats obtenus par le Cerema sont comparables à ce que l’on constate généralement dans le domaine de l’Intelligence Artificel lorsqu’on utilise les indicateurs académiques (matrices de confusion, Kappa et Fscore). Le passage au crible de la norme et d’un protocole plus strict, conforte même ces conclusions. En contrepartie, si l’on s’intéresse à l’ adéquation de la donnée à un usage spécifique, on peut conclure de manières très divergentes sur les résultats.

En l’absence de connaissances, par exemple l’identification de la végétation urbaine, une donnée imparfaite conserve une valeur d’usage pertinente. A contrario, il est délicat ou impossible de mesurer les dynamiques urbaines si elles sont inférieures aux incertitudes de la mesure.

Pour situer les résultats produits sur la base des images satellites dans un contexte plus général, le Cerema a conduit une étude comparative sur la question de la mesure de l’artificialisation via plusieurs bases de données (Corine Land Cover , OSO Theia, OSCOM, OCS GE, fichiers fonciers et OCS Sat Cerema,). Il est apparu qu’aucun produit ne mesure les mêmes valeurs à une date donnée, ni sur les dynamiques d’évolution, où des désaccords sur les tendances peuvent même être observés.

Le collège de chercheurs (ESCO INRA et IFSTTAR)2 mandaté par le MTES pour travailler sur la question de l’artificialisation des sols a conclu qu’à ce jour, il n’y a pas de consensus sur la quantification absolue de ce phénomène entre les différentes sources de données disponibles.

Ces démarches mettent en lumière le manque d’information sur la qualité d’usage des bases de données.

Conclusion

Aujourd’hui, la profusion de données et d’outils facilite la production d’indicateurs et de cartes de toutes sortes sur lesquelles des politiques publiques sont définies ou évaluées sans connaître précisément la fiabilité des données.

Sur la base de ces exemples, la qualification de la donnée semble un enjeu crucial : elle doit éclairer sur la confiance que nous pouvons accorder aux données. Néanmoins, l’étude présentée ici met en évidence la part importante que peut représenter la qualification de la donnée dans le décompte global des coûts de production.

Si aujourd’hui les méthodes d’automatisation permettent de satisfaire à moindres frais un premier niveau de besoin, l’estimation fine de phénomènes nécessite de mettre en œuvre des méthodes plus poussées et une qualification rigoureuse qui impliquent une augmentation significative des coûts.

Auteurs : Amélie Lombard et Dominique Hébrard (Cerema)

1https://www.cerema.fr/fr/actualites/serie-fiches-cerema-qualifier-donnees-geographiques

2http://institut.inra.fr/Missions/Eclairer-les-decisions/Expertises/Toutes-les-actualites/Sols-artificialises-et-processus-d-artificialisation-des-sols