Cet article est issu de l’interview de Clément Jamet, Ingénieur données à la Métropole de Lyon. Clément Jamet fait partie de l’Unité Données de références et 3D, au sein du Service Géomatique et Données Métropolitaines, qui se charge de la gestion de la donnée brute et de son parcours jusqu’à sa diffusion (OpenData, intégration à d’autres bases de données…).

D’autres unités de la Métropole travaillent sur les données :

-

l’Unité de Topographie et de délimitation du domaine public ;

-

l’Unité Diffusion des données (qui s’occupe notamment du portail OpenData).

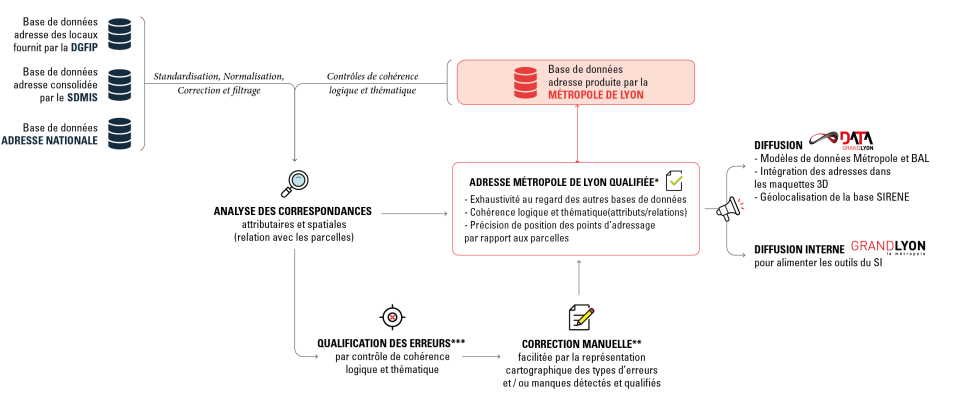

Dans le cadre de la politique OpenData de la Métropole de Lyon, la qualité des données est un enjeu important, principalement pour les réutilisations. Clément Jamet revient sur ce qui est mis en place à la Métropole : les enjeux autour de la qualité, et les grands chantiers sur le sujet. Pour illustrer les propos, nous effectuerons ensuite un zoom sur la gestion des données adresse.

Quels sont les enjeux de la qualité des données pour la Métropole de Lyon ?

Il y a deux enjeux majeurs autour de la qualité des données géographiques :

-

Le premier est d’assurer un niveau de qualité dans la production des données. Les objectifs sont à la fois de fournir des données utiles, de constituer des socles de références, ainsi que d’être légitime pour alimenter des standards nationaux.

-

Le deuxième enjeu est la qualification : pouvoir donner l’information sur la qualité des données produites, notamment pour faciliter les réutilisations, en interne comme par le grand public via les données ouvertes. La qualification est également indispensable pour l’alimentation de bases de données au niveau national.

L’automatisation des process de qualification est un sujet d’actualité. Il est important de pouvoir intégrer à l’exploitation de la donnée des informations permettant de calculer un indice d’incertitude. On peut alors prendre la valeur d’incertitude basse ou haute selon le besoin de tolérance. Dans ce cadre, les fiches du Cerema aident à consolider certaines procédures qui permettent de qualifier la donnée.

Dans le contexte de l’analyse de gros volumes de données, il est important de standardiser cette notion de qualité, pour qu’elle soit intégrée dans des process pour hiérarchiser l’incertitude des données. Au-delà de la méthode proposée par le Cerema, l’un des besoins est donc de standardiser informatiquement les critères qualité.

De même, il est utile de publier les données dans des formats standards (CityGML, Base Adresse Locale – BAL – d’OpenDataFrance, GML, PCRS, INSPIRE), car on trouve des outils qui permettent de valider ou de contrôler la qualité (valid3city, data.gouv.fr ou le BAL). Cela permet de respecter un niveau de qualité et de mutualiser les outils de contrôle.

Quels sont les grands chantiers en cours ?

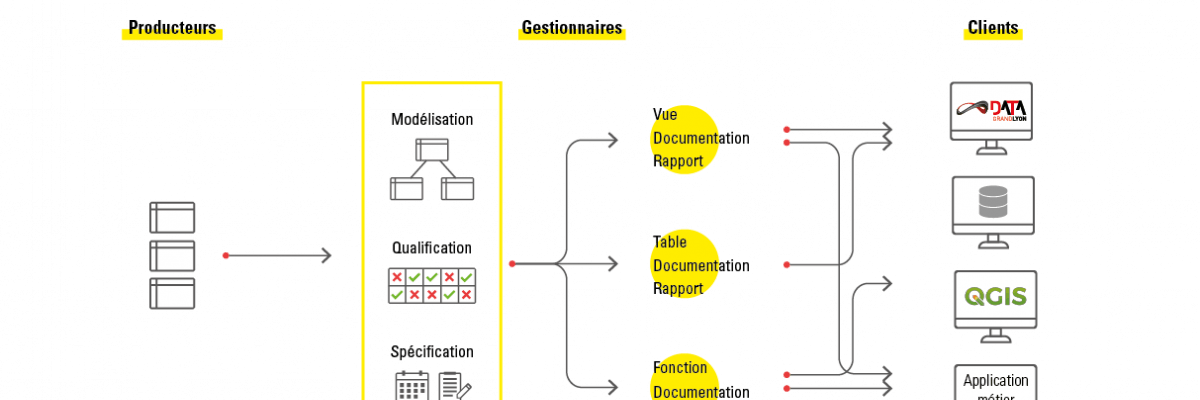

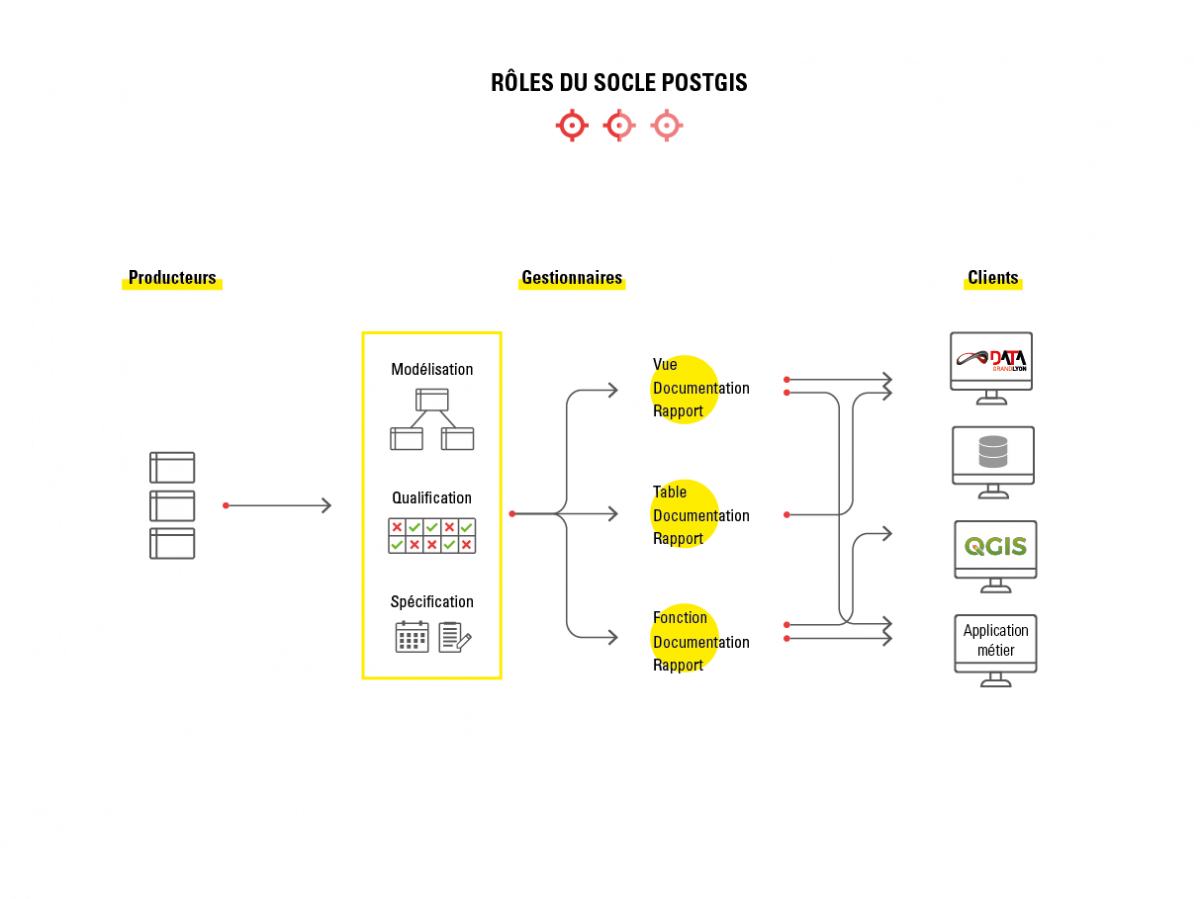

L’intégration de la mise en qualité des données dès le process de production est un premier chantier. Par ce biais, on peut, dès la production des données, vérifier notamment les critères de qualité géométrique et de complétion attributaire. Cela se fait grâce à la mise en place de contrôles automatiques dans les bases de saisies et dans les environnements de recette et de production.

Au-delà de l’action sur la production, la qualité est intégrée à l’ensemble du parcours de la donnée. Dans le process de migration de la donnée jusqu’au portail OpenData, on contrôle le niveau de qualité, ce qui permet d’alimenter les métadonnées et aussi d’avoir des seuils qui peuvent bloquer la propagation de la donnée. Afin de pouvoir élargir à l’ensemble des données cette procédure, aujourd’hui restreinte à quelques jeux de données spécifiques, nous devons définir, pour chaque donnée produite, des critères et des seuils acceptables. Ces seuils d’acceptabilité dépendent de l’usage : ils seront plus bas pour des usages internes de données peu sensibles, et plus haut pour la diffusion en OpenData des données destinées à l’alimentation de base de données nationales.

Si les process de contrôle qualité commencent à être en place, ils ne permettent pas la restitution des métadonnées « qualité ». Aujourd’hui, l’un des objectifs est de générer en sortie une fiche qualité. L’effort est aussi porté, pour les données OpenData, sur le renseignement de la généalogie, en attendant que des critères chiffrés et plus complets soient fournis.

Enfin, dans le cadre de la réception de l’Ortho 2018, le contrôle de la qualité de la livraison servira à fournir des informations qualitatives pour les métadonnées.